El aumento del uso de la inteligencia artificial (IA) en todos los sectores es imparable. Independientemente de la opinión que podamos tener sobre su uso, lo cierto es que difícilmente va a haber una vuelta atrás. Tal y como señalan los expertos, utilizados de forma correcta, crean oportunidades para que las empresas sean más eficientes, reduzcan costes y en última instancia, mejoren la experiencia de los clientes.

Sin embargo, el uso de estos modelos en sectores tan sensibles como puede ser el de los servicios financieros, conllevar retos adicionales a los que merece que se preste una atención especial. Por ejemplo, el uso de esta IA a la hora de hacer un perfilado de la población, puede llevar a replicar prejuicios injustos que dificulten el acceso al crédito y otras opciones de financiación para determinados grupos. Esta realidad, de la que hemos hablado en otras ocasiones y sobre la que han advertido los expertos, acaba de ser refrendada hace unos días por el propio Banco de Inglaterra, que ha advertido que el uso de IA podría convertirse en un riesgo para los servicios financieros.

¿De qué forma se pueden introducir sesgos en un modelo de IA?

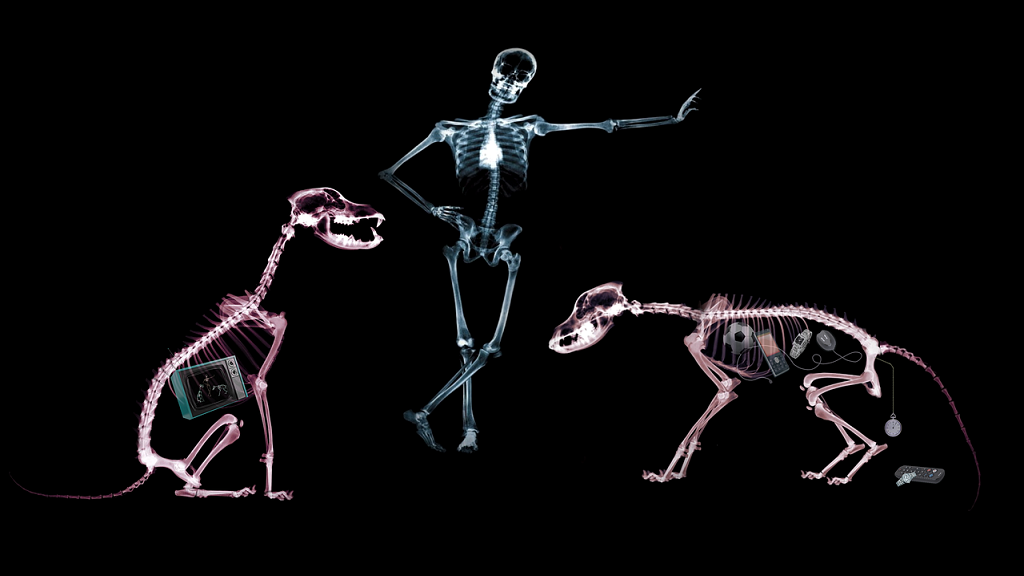

Las etapas de desarrollo de un modelo de IA (o, más concretamente, el algoritmo que dirige el modelo) ayudan a comprender los riesgos potenciales de sesgo. Así, el sesgos puede introducirse en en el modelo de varias formas. Puede ser que el propio algoritmo cree un sesgo debido a la forma en que se implementa, al dar más importancia a ciertos datos, frente a otros que debería considerar de manera similar, creando un desequilibrio. También podrían introducirlo los propios creadores del algoritmo, al ser los responsables de escoger qué conjuntos de datos deben incluirse o excluirse en el modo de IA. Sin embargo, la forma más habitual de sesgo se produce en el propio contenido de los datos que se encuentran dentro del conjunto de datos utilizado.

Hay que tener en cuenta que los modelos de IA son tan buenos como los datos con los que se entrenan y que los conjuntos de datos pueden obtenerse de varias maneras. Así que veamos algunas situaciones que pueden darse en el sector financiero. Puede ocurrir que una empresa utilice sus propio histórico de datos para crear un conjunto propio: por ejemplo, toda la información que tiene sobre siniestros de seguros para mejorar la evaluación de riesgos y la estimación de primas. Otra posibilidad que esa empresa decida comprar distintos conjuntos de datos a terceros que los han recopilado a través de Internet u otras fuentes. En ambos casos, existe el riesgo de que los datos estén sesgados, ya que a menudo reflejan las desigualdades de la sociedad.

Por ejemplo, los datos pueden dar preferencia a los hombres blancos sobre las mujeres o los grupos étnicos minoritarios. Si el conjunto de datos se entrena a partir de datos históricos sesgados en contra de los grupos étnicos minoritarios, podría dar lugar a un sistema de tarifas o de decisiones que discrimine a un sector determinado. Un ejemplo bien documentado de este sesgo fue el modelo de IA de contratación de Amazon, que resultó ser discriminatorio contra las mujeres.

Conjuntos de datos justos y transparentes

¿Cómo podemos detener el sesgo en los modelos de IA? Aunque los expertos han propuesto varias formas, ninguna metodología es en realidad infalible. Sin embargo sí que es verdad que hay mucho que se puede hacer para si no eliminar el riesgo de un modelo sesgado por completo, sí al menos reducirlo considerablemente.

En primer lugar, los conjuntos de datos deben ser transparentes para que puedan analizarse en busca de sesgos. Por ejemplo, debe quedar claro cómo y cuándo se obtuvieron y etiquetaron los datos. En este sentido, resulta fundamental tener en cuenta y analizar el perfil socio-demográfico de las personas que forman parte de cualquier conjunto de datos. Esta información permitirá determinar hasta qué punto el conjunto de datos es adecuado para los fines del modelo de IA y si puede haber algún sesgo discriminatorio.

No siempre se trata de un ejercicio sencillo, ya que dependerá del tamaño del conjunto de datos y de si se trata de datos propios o adquiridos a terceros. En relación con esto último, será importante comprender las condiciones de uso de cualquier conjunto de datos adquirido, para aclarar dónde podría estar el riesgo y la responsabilidad en caso de que el conjunto de datos pudiese dar lugar a problemas legales en un futuro.

También es importante supervisar y evaluar continuamente el modelo de IA. Es importante que las empresas sometan sus modelos de IA a pruebas de estrés para asegurarse de que su objetivo se cumple, que realiza valoraciones justas y que en función de un variado número de circunstancias, produce resultados equilibrados, libres de sesgos.

Esto significa contar con un equipo de auditoría interna que comprenda el modelo de IA, los conjuntos de datos utilizados y los datos continuos que se añadirán al modelo de IA en tiempo real para garantizar que los resultados no sean discriminatorios. Para ello deben existir políticas que garanticen cualquier cambio necesario y que haya que introducir en los modelos de IA pueda realizarse a escala, de forma eficaz y rápida. Y esto es especialmente importante, si tenemos en cuenta los esfuerzos que están haciendo organismos como la UE a la hora de establecer un marco regulatorio para la IA, y que se muestran cada vez más interesados en garantizar que los modelos sean completamente transparentes, funcionando en beneficio de los clientes.